AI4ESS 2020:机器和统计学习基础:通用框架,推断与预测

本文翻译自 AI4ESS 2020 课程,并有部分修改

Artificial Intelligence for Earth System Science (AI4ESS) Summer School

Machine and Statistical Learning Fundamentals

Dorit Hammerling - CSM / NCAR

通用框架,推理与预测

有用的参考书

免费,并且写得很好,都有良好的代码示例

An Introduction to Statistical Learning with Applications in R

数学内容较少。

The Elements of Statistical Learning

更偏向于数学。

面向初学者的一些定义

统计学习(Statistical learning):大量可从数据中获取见解的工具

监督 vs 非监督:输出 + 一个或更多的输入

- 分类

- 回归

- 。。。

监督学习:只有输入,对这些输入的结构更感兴趣

- 聚类

- 相关分析

- 降维,例如主成分分析

本讲座将聚焦监督学习。

基本模型方程

监督模型的最简单形式

$$ Y = f(X) + \varepsilon $$

模型构成:

\(Y\):我们感兴趣的一些变量,输出

\(f\):关于 \(X\) 的某种固定但未知的函数

\(X\):变量 \(X_{1},…,X_{p}\),我们相信可能与 \(Y\) 有某种关联,输入

\(\varepsilon \):随机误差项

机器学习的主要目标:

估计 \(f\)

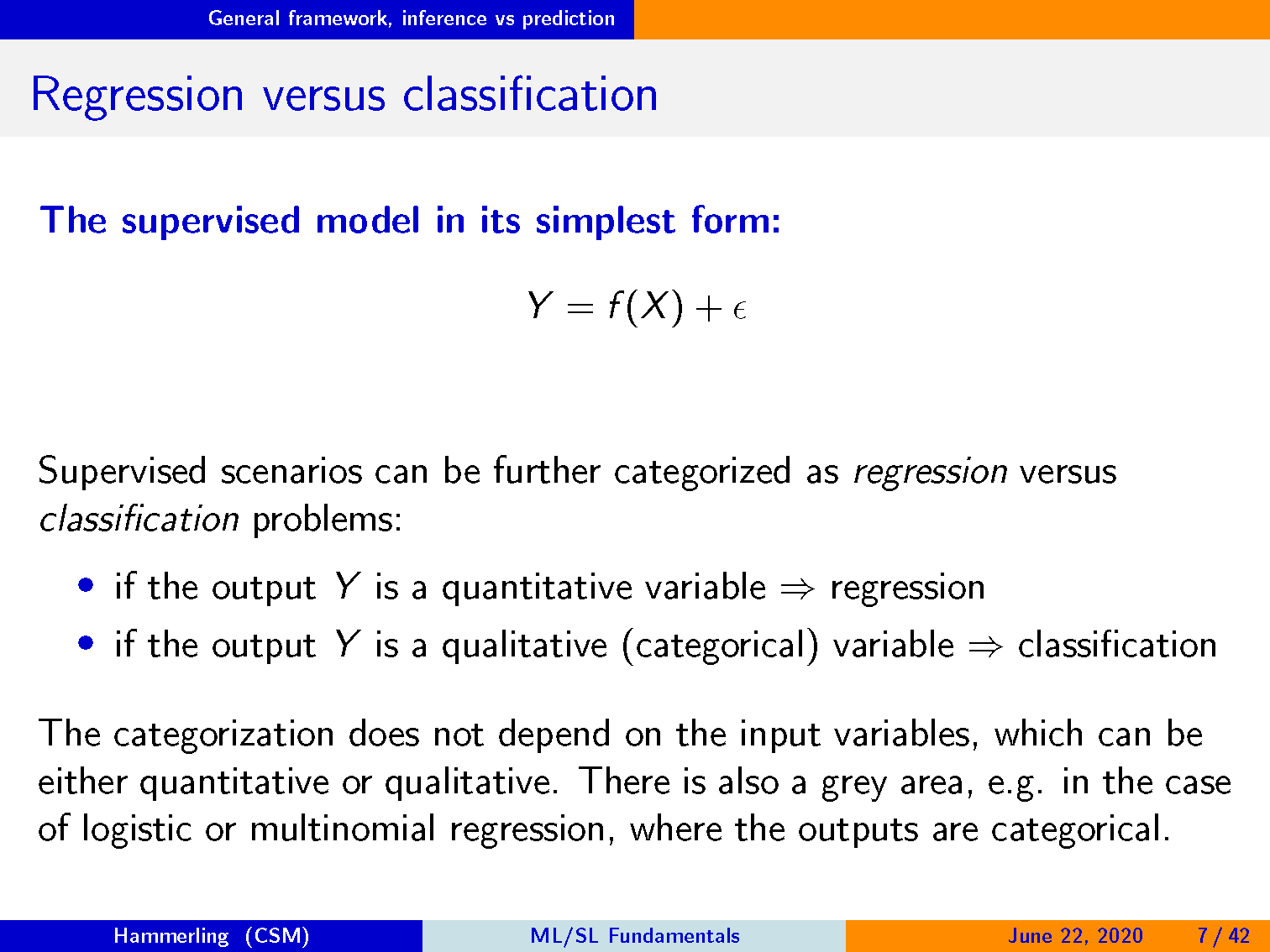

回归 vs 分类

监督学习的场景可以分成回归(regression)和分类(classification)两类问题:

- 如果输出 \(Y\) 是定量变量 => 回归

- 如果输出 \(Y\) 是定性(类别)变量 => 分类

上述类别不依赖于输入变量,输入变量即可以是定量变量,也可以是定性变量。

还有一个灰色区域,例如在逻辑或多项式回归的情况下,输出是分类的。

为什么想要估计 \(f\)

两个主要的原因:

- 预测:如果我们获得一个新的 \(X\),想要得到对应的 \(Y\)

- 推理:\(X\) 和 \(Y\) 之间的关系是什么

我们的动机会影响我们选择模型 \(f\) 的方法!

在预测准确性和模型可解释性之间进行权衡:

更简单,更不灵活的模型通常更易于解释,但可能不如更灵活的模型准确。

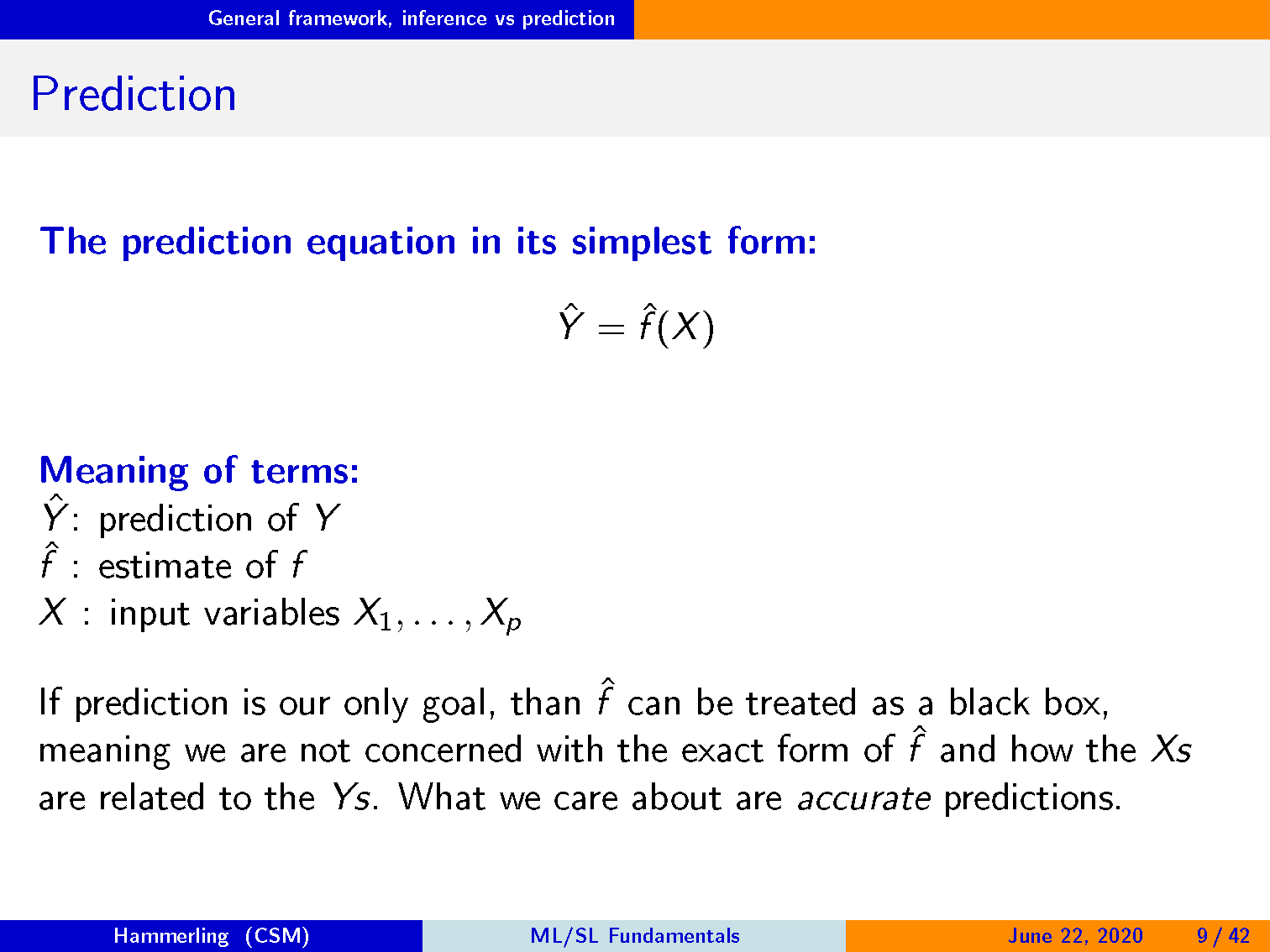

预测

预测等式的简单形式

$$ \hat{Y} = \hat{f}(X) $$

变量含义

\(\hat{Y}\):\(Y\) 的预测

\(\hat{f}\):\(f\) 的估计

\(X\):输入变量,\(X_{1},…,X_{p}\)

如果我们的目标仅仅是预测结果,那么可以将 \(\hat{f}\) 当成一个黑箱。

这意味着我们不关心 \(\hat{f}\) 的精确形式,也不关心 Xs 是如何与 Ys 关联的。

我们关心的是 准确 的预测。

预测精度

我们预测的 \(\hat{Y}\) 与真实值 \(Y\) 有多接近?

通常表示为 Y 的预测值和真实值之间的平方差,它取决于两个误差分量。

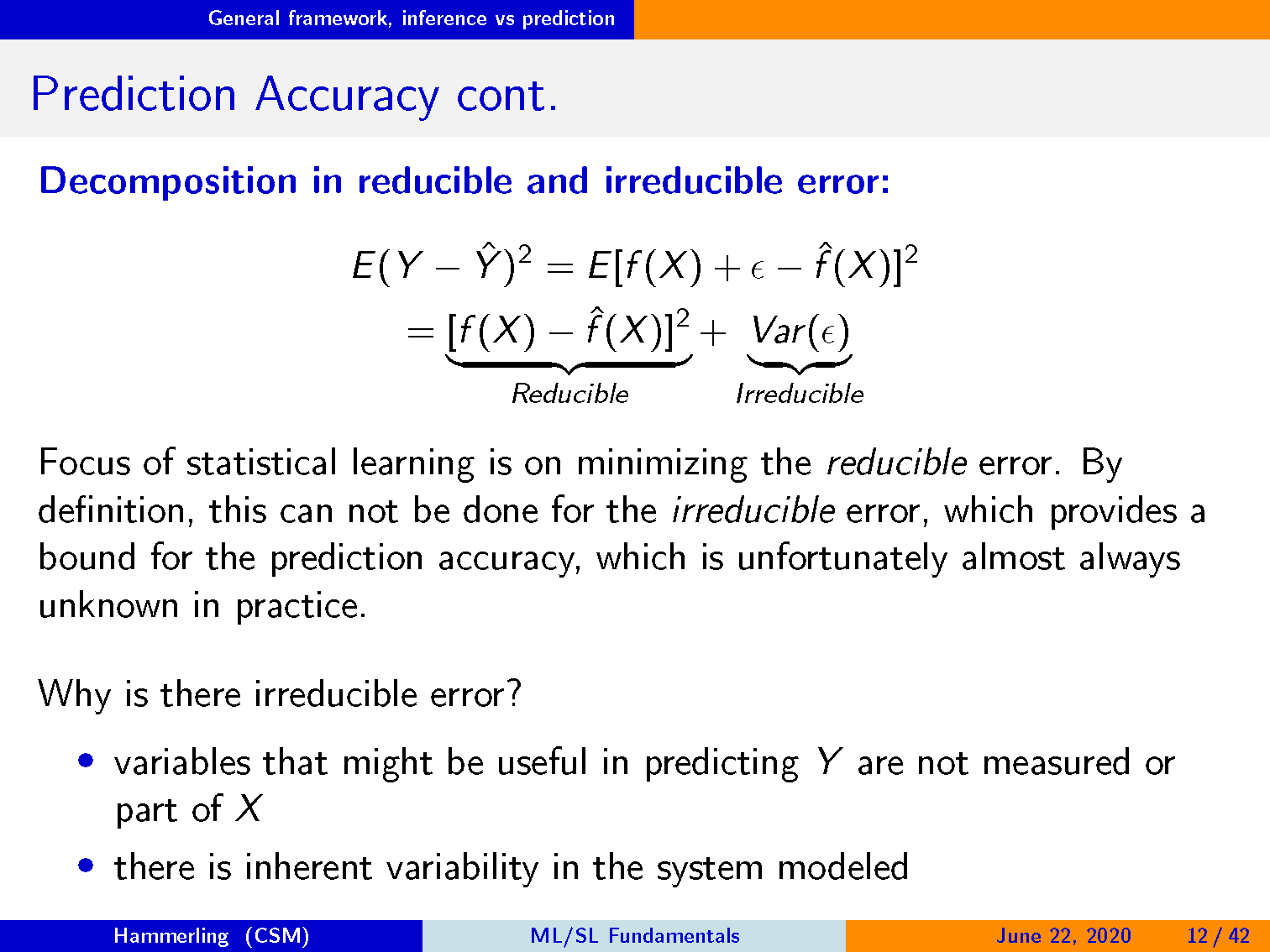

可减少的误差和不可减少的误差的分解:

\begin{equation*} E(Y-\hat{Y})^{2}=E[f(X)+\epsilon - \hat{f}(X)]^{2} \\ = \underbrace{[f(X)-\hat{f}(X)]}{Reducible} + \underbrace{Var(\epsilon )}{Irreducible} \end{equation*}

解释不可减少的误差

Figure credit: Introduction to Statistical Learning, Figure 2.2

预测精度(续)

统计学习的重点在于最小化可减少的误差。 根据定义,这对于不可减少的误差是无法做到的,这为预测精度提供了一个界限。 不幸的是,在实践中这种界限几乎总是未知的。

为什么会有不可减少的误差?

- 对于预测 \(Y\) 可能有用的变量没有测量,或不是 \(X\) 的组成部分。

- 在建模的系统中存在固有的可变性

推断

我们想要理解 \(X\) 和 \(Y\) 之间的关系,特别是 \(Y\) 如何以 \(X_{1},…,X_{p}\) 的函数形式进行变化。

在这种情况下,我们 不能 将 \(\hat{f}\) 作为黑箱,我们更关注它的确切形式。

推断领域中出现的典型问题:

- 哪些预测因素与响应有关? => 变量选择

- 预测变量与响应之间的关系的本质是什么? => 模型选择

在某些情况下,我们对预测和推断都感兴趣。